防不胜防 杀手机器人来了

2017-11-27 10:13:29 来源 : 澎湃新闻中国国际警用装备网讯: 上周,在日内瓦举办的联合国特定常规武器公约会议上,一段可怕的视频公诸于众:视频中,一群神似《黑镜III》中机器杀人蜂的小型机器人,通过人脸定位瞬间杀死了正在上课的一众学生,场面血腥。

伯克利大学教授、资深AI研究者Stuart Russell在视频的最后提醒人们,想象一下,这些致命的自动武器一旦落入恐怖分子之手,可能造成怎样的后果。

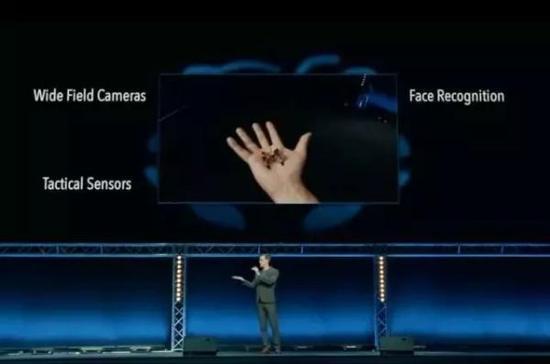

先来看看视频里几个可怕的画面:

一个体型类似蜜蜂的小型机器人飞入会场并轻易躲过演讲人抓捕,其拥有 anti-sniper 技术,完全基于 AI。

这个小东西蕴含可怕的黑科技:广角摄像头、传感器、面部识别,且在其中部,还有3克炸药。

来看看它的攻击效果,一击而中,极端致命。来看看它的攻击效果,一击而中,极端致命。

看到这个武器,小编立马想起了《三体》里一种终极形态的武器——“水滴”,它形状与普通水滴相似,由被强互作用力紧密锁死的质子与中子构成,密度巨大,无坚不摧,仅一个水滴就能接连摧毁人类的一千多艘飞船,打击方式也是直接、精准穿透关键部位,和这段视频里一样。

视频最后还演示了一段飞行机器人集体攻击人类的画面,通过面部识别定位,轻易杀死了正在上课的一班学生。

在视频结尾,Russell发出警告,尽管这段视频和其中的杀人机器人并非真实,但视频中的科技目前已经存在。要避免视频中的悲剧发生,我们需要尽快行动。

这段视频发布在本月13-17日的联合国特定常规武器公约会议上,这一会议由“杀手机器人禁令运动”(Campaign to Stop Killer Robots)组织,超过七十个国家的代表出席。

杀手机器人:未来无人战争之忧

今年8月20日,在墨尔本举行的2017国际人工智能联合大会上,包括美国特斯拉电动汽车公司CEO伊隆·马斯克、DeepMind联合创始人穆斯塔法·苏莱曼在内的116位机器人和人工智能公司创始人发表公开信,呼吁联合国在国际范围内禁止“致命性自主武器系统”的使用。

公开信指出,致命性自主武器系统足以构成第三次武器革命的威胁——前两次革命分别是火药和核武器。这种技术一旦开发成功,将有可能把战争冲突升级至从未有过的规模,而且会达到人类难以控制的速度。公开信的签署者们认为,致命性自主武器可能成为独裁者和恐怖分子残害无辜的手段,或者被黑客挟持。

致命性自主武器系统实际上是一种军用机器人,它可以不经过人类干预,自主选择和攻击包括人员和装备在内的军事目标,所以也被叫做“杀手机器人”。目前,拥有“人格”的智能技术尚未被从科幻电影搬到现实中,但是与此有关的技术的确正在朝着这个方向发展。

有人认为,在未来,致命性自主武器系统如果应用于战争,在军事方面会起到许多正面作用。例如,降低己方士兵的风险,降低人与人之间近距离战争的代价。此外,自主武器系统也省去了军人的薪水、住房、养老、医疗等开销,又在速度、准确性上高于人类,而且不用休息。有别于人类战斗员会在战场上出现心理和情绪波动的特点,人工智能武器更稳定,并且能够抵达人类不可及之处,完成搜救和保护任务。

西安政治学院军事法学系教授宋新平分析,致命性自主武器的运用,意味着自然人在武装冲突中直接发挥的作用越来越小,武器所发挥的作用则越来越大,将影响并改变未来战场的战斗员构成与战斗能力的变化,特别是这种武器的集群式运用,对未来作战的指挥体制、力量运用、供给保障等方面将产生革命性影响。

正在海上进行试验的美国Sea Hunter自主战舰。正在海上进行试验的美国Sea Hunter自主战舰。

争议“杀手机器人”

但是,随着致命性自主武器系统的发展,它所带来的争议也越来越强烈。

首先,有人担忧,机器打仗使得人员伤亡大大减少,反过来又会降低战争发动的门槛,武装冲突发生的机会会增加,而战争的人员损失将从战斗员转移到交火区域的平民。

其次,如同所有战争中的武器一样,致命性自主武器系统要运用在战争中,必须符合《日内瓦公约》,即国际人道法。反对者认为,该武器系统违反国际人道法中的“区分原则”,即机器人武器很难做到和人类一样区分平民与战斗员、有战斗能力的战斗员和丧失战斗能力的战斗员(如伤者、病者及战俘),以及作战人员和携带轻武器从事非战斗任务的人员。

在伦理方面,致命性自主武器运用于未来的武装冲突中,这意味着将剥夺自然人生命的权利交给非自然人。有学者认为,这是将人的生命和人格尊严交给机器来判定,不具有平等性,也是对人类生命权以及人格尊严的侮辱。

法律上的责任更是不能忽略。自主武器兼具“战斗员”和“战斗武器”两种角色,如果它违背国际人道法,国际社会将面临如何追究责任的问题,而被追究的主体应该是设计者、制造者、操作者还是机器本身?

今年8月发出的公开信不是伊隆·马斯克等人第一次对致命性自主武器系统提出警示。早在2015年,同样在国际人工智能联合大会上,物理学家斯蒂芬·霍金、苹果联合创始人史蒂夫·沃兹尼亚克等1000多名人工智能领域专家联合谴责人工智能时代的军备竞赛,呼吁禁止自主武器。容易引发军备竞赛、威胁世界和平,是反对者担忧的原因之一。

但是,也有人认为以上反对意见作为禁用致命性自主武器的理由站不住脚。研究人工智能哲学的复旦大学教授徐英瑾在《技术与正义:未来战争中的人工智能》一文中进行了反驳。比如,对于“无人智能武器的出现,会使得杀戮变得更为容易,因此,也会使得军事暴力在未来变得更为频繁”的说法,徐英瑾提出,按照杀戮效率提高会对和平构成威胁的逻辑,那是否为了降低杀戮效率,就制造尽量劣质的枪支,鼓励士兵降低击中率?这显然是荒谬的,相反,人工智能技术运用于军事,会使得人类作战意图得到更精确的贯彻,可使得正义战争快速结束。

人工智能公司、国际组织纷纷呼吁禁止致命性自主武器系统,但现状是,至今国际社会仍然没有就致命性自主武器系统问题达成统一认识,甚至还没有统一的定义。

联合国《特定常规武器公约》成员国已经建立了一个致命性自主武器系统的政府专家小组,这个小组的第一次会议预定将于今年11月召开。伊隆·马斯克等公开信签署者希望专家小组努力寻求方法,防止这类武器的军备竞赛,保护平民免受武器滥用的伤害,避免这些技术给世界的未来带来严重的后果。

新闻稿件欢迎直接联系:QQ 34004818 微信公众号:cpsjyzb

我要评论

0 条评论

- 还没有人评论过,赶快抢沙发吧!

加入收藏

加入收藏 加关注

加关注 登录

登录

注册

注册

微警用

微警用